ai-agents-for-beginners

การใช้งานโปรโตคอล Agentic (MCP, A2A และ NLWeb)

(คลิกที่ภาพด้านบนเพื่อดูวิดีโอของบทเรียนนี้)

เมื่อการใช้งาน AI Agents เพิ่มขึ้น ความต้องการโปรโตคอลที่ช่วยให้เกิดมาตรฐาน ความปลอดภัย และสนับสนุนการสร้างนวัตกรรมแบบเปิดก็เพิ่มขึ้นเช่นกัน ในบทเรียนนี้ เราจะพูดถึง 3 โปรโตคอลที่ตอบสนองความต้องการนี้ ได้แก่ Model Context Protocol (MCP), Agent to Agent (A2A) และ Natural Language Web (NLWeb)

บทนำ

ในบทเรียนนี้ เราจะพูดถึง:

• วิธีที่ MCP ช่วยให้ AI Agents เข้าถึงเครื่องมือและข้อมูลภายนอกเพื่อทำงานตามคำขอของผู้ใช้

• วิธีที่ A2A ช่วยให้ AI Agents ต่าง ๆ สื่อสารและทำงานร่วมกันได้

• วิธีที่ NLWeb นำอินเทอร์เฟซภาษาธรรมชาติมาสู่เว็บไซต์ใด ๆ เพื่อให้ AI Agents สามารถค้นหาและโต้ตอบกับเนื้อหาได้

เป้าหมายการเรียนรู้

• ระบุ วัตถุประสงค์หลักและประโยชน์ของ MCP, A2A และ NLWeb ในบริบทของ AI Agents

• อธิบาย วิธีที่แต่ละโปรโตคอลช่วยให้เกิดการสื่อสารและการโต้ตอบระหว่าง LLMs, เครื่องมือ และ AI Agents อื่น ๆ

• รับรู้ บทบาทที่แตกต่างกันของแต่ละโปรโตคอลในการสร้างระบบ Agentic ที่ซับซ้อน

Model Context Protocol

Model Context Protocol (MCP) เป็นมาตรฐานเปิดที่ให้วิธีการที่เป็นมาตรฐานสำหรับแอปพลิเคชันในการให้บริบทและเครื่องมือแก่ LLMs สิ่งนี้ช่วยให้เกิด “อะแดปเตอร์สากล” สำหรับแหล่งข้อมูลและเครื่องมือที่ AI Agents สามารถเชื่อมต่อได้ในรูปแบบที่สอดคล้องกัน

เรามาดูส่วนประกอบของ MCP, ประโยชน์เมื่อเทียบกับการใช้งาน API โดยตรง และตัวอย่างการใช้งาน MCP Server โดย AI Agents

ส่วนประกอบหลักของ MCP

MCP ทำงานบน สถาปัตยกรรม client-server และมีส่วนประกอบหลักดังนี้:

• Hosts คือแอปพลิเคชัน LLM (เช่น โปรแกรมแก้ไขโค้ดอย่าง VSCode) ที่เริ่มการเชื่อมต่อไปยัง MCP Server

• Clients คือส่วนประกอบภายในแอปพลิเคชัน host ที่รักษาการเชื่อมต่อแบบหนึ่งต่อหนึ่งกับเซิร์ฟเวอร์

• Servers คือโปรแกรมน้ำหนักเบาที่เปิดเผยความสามารถเฉพาะ

โปรโตคอลนี้มีองค์ประกอบหลักสามอย่างที่เป็นความสามารถของ MCP Server:

• Tools: เป็นการกระทำหรือฟังก์ชันที่ AI Agent สามารถเรียกใช้เพื่อดำเนินการ ตัวอย่างเช่น บริการพยากรณ์อากาศอาจมีเครื่องมือ “get weather” หรือเซิร์ฟเวอร์อีคอมเมิร์ซอาจมีเครื่องมือ “purchase product” MCP Servers โฆษณาชื่อเครื่องมือ คำอธิบาย และรูปแบบ input/output ในรายการความสามารถของพวกเขา

• Resources: เป็นข้อมูลหรือเอกสารที่ MCP Server สามารถให้ได้ และ Clients สามารถดึงข้อมูลเหล่านี้ได้ตามต้องการ ตัวอย่างเช่น เนื้อหาไฟล์ บันทึกฐานข้อมูล หรือไฟล์บันทึกข้อมูล Resources อาจเป็นข้อความ (เช่น โค้ดหรือ JSON) หรือไบนารี (เช่น รูปภาพหรือ PDF)

• Prompts: เป็นเทมเพลตที่กำหนดไว้ล่วงหน้าซึ่งให้คำแนะนำสำหรับการทำงานที่ซับซ้อนมากขึ้น

ประโยชน์ของ MCP

MCP มีข้อดีสำคัญสำหรับ AI Agents:

• การค้นหาเครื่องมือแบบไดนามิก: Agents สามารถรับรายการเครื่องมือที่มีอยู่จากเซิร์ฟเวอร์พร้อมคำอธิบายของเครื่องมือเหล่านั้นได้แบบไดนามิก ซึ่งแตกต่างจาก API แบบดั้งเดิมที่มักต้องการการเขียนโค้ดแบบคงที่สำหรับการรวมระบบ ซึ่งหมายความว่าการเปลี่ยนแปลง API ใด ๆ จำเป็นต้องมีการอัปเดตโค้ด MCP เสนอวิธีการ “รวมครั้งเดียว” ซึ่งนำไปสู่ความสามารถในการปรับตัวที่มากขึ้น

• การทำงานร่วมกันระหว่าง LLMs: MCP ทำงานร่วมกับ LLMs ต่าง ๆ ได้ ทำให้มีความยืดหยุ่นในการเปลี่ยนโมเดลหลักเพื่อประเมินประสิทธิภาพที่ดีกว่า

• ความปลอดภัยที่เป็นมาตรฐาน: MCP มีวิธีการรับรองความถูกต้องที่เป็นมาตรฐาน ซึ่งช่วยเพิ่มความสามารถในการปรับขนาดเมื่อเพิ่มการเข้าถึง MCP Servers เพิ่มเติม สิ่งนี้ง่ายกว่าการจัดการคีย์และประเภทการรับรองความถูกต้องที่แตกต่างกันสำหรับ API แบบดั้งเดิม

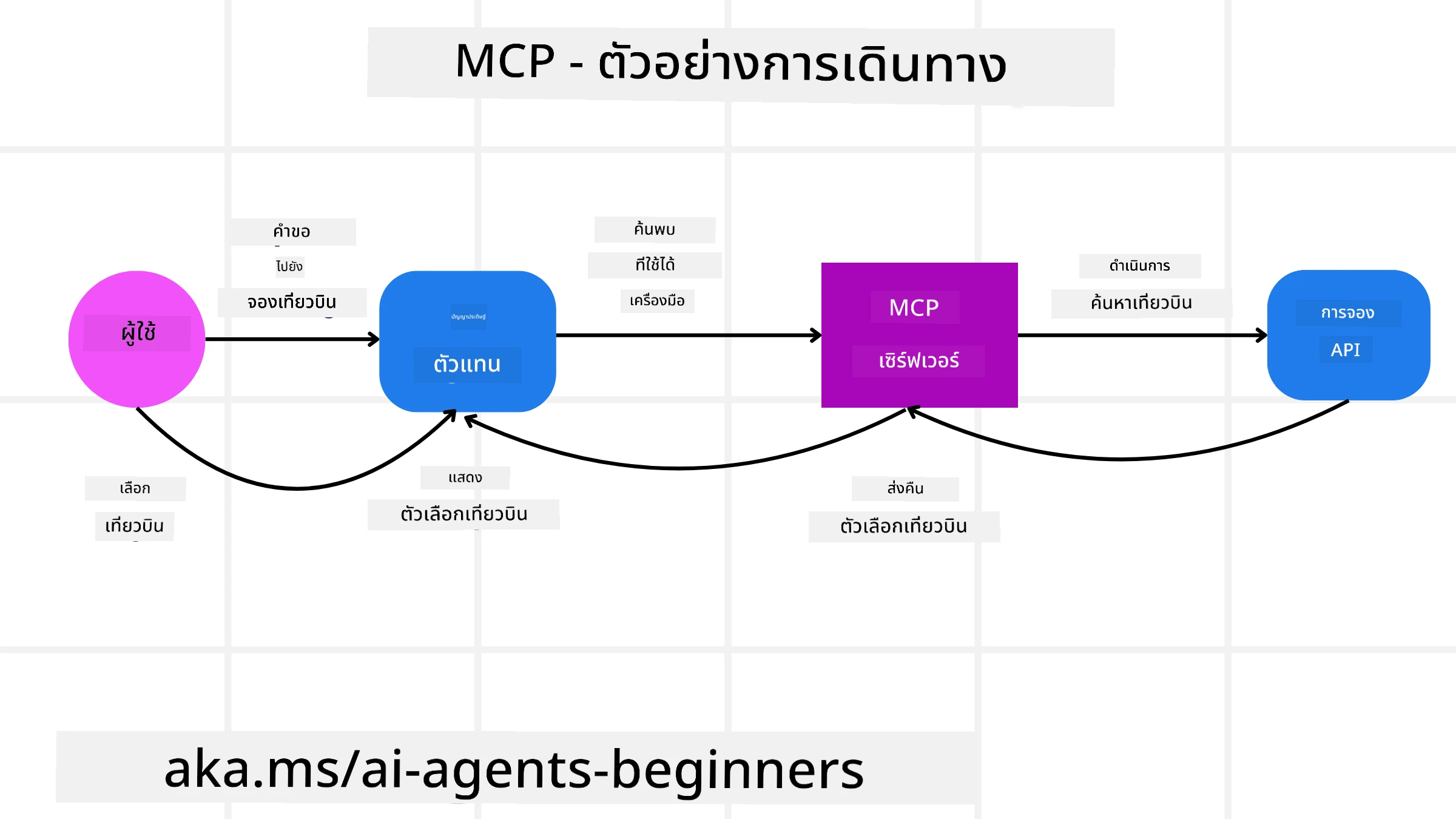

ตัวอย่าง MCP

ลองจินตนาการว่าผู้ใช้ต้องการจองเที่ยวบินโดยใช้ AI Assistant ที่ขับเคลื่อนด้วย MCP

-

การเชื่อมต่อ: AI Assistant (MCP Client) เชื่อมต่อกับ MCP Server ที่ให้บริการโดยสายการบิน

-

การค้นหาเครื่องมือ: Client ถาม MCP Server ของสายการบินว่า “มีเครื่องมืออะไรบ้าง?” เซิร์ฟเวอร์ตอบกลับด้วยเครื่องมือ เช่น “search flights” และ “book flights”

-

การเรียกใช้เครื่องมือ: ผู้ใช้ขอให้ AI Assistant “ค้นหาเที่ยวบินจาก Portland ไป Honolulu” AI Assistant ใช้ LLM เพื่อระบุว่าต้องเรียกใช้เครื่องมือ “search flights” และส่งพารามิเตอร์ที่เกี่ยวข้อง (ต้นทาง ปลายทาง) ไปยัง MCP Server

-

การดำเนินการและการตอบกลับ: MCP Server ทำหน้าที่เป็นตัวกลางในการเรียก API การจองภายในของสายการบิน จากนั้นรับข้อมูลเที่ยวบิน (เช่น ข้อมูล JSON) และส่งกลับไปยัง AI Assistant

-

การโต้ตอบเพิ่มเติม: AI Assistant นำเสนอทางเลือกเที่ยวบิน เมื่อผู้ใช้เลือกเที่ยวบิน AI Assistant อาจเรียกใช้เครื่องมือ “book flight” บน MCP Server เดียวกันเพื่อทำการจองให้เสร็จสมบูรณ์

Agent-to-Agent Protocol (A2A)

ในขณะที่ MCP มุ่งเน้นการเชื่อมต่อ LLMs กับเครื่องมือ Agent-to-Agent (A2A) Protocol ก้าวไปอีกขั้นโดยช่วยให้ AI Agents ต่าง ๆ สื่อสารและทำงานร่วมกันได้ A2A เชื่อมต่อ AI Agents ข้ามองค์กร สภาพแวดล้อม และเทคโนโลยีเพื่อทำงานร่วมกันในงานที่แชร์

เราจะตรวจสอบส่วนประกอบและประโยชน์ของ A2A พร้อมตัวอย่างการใช้งานในแอปพลิเคชันการเดินทางของเรา

ส่วนประกอบหลักของ A2A

A2A มุ่งเน้นการสื่อสารระหว่าง Agents และการทำงานร่วมกันเพื่อทำงานย่อยของผู้ใช้ให้เสร็จสมบูรณ์ แต่ละส่วนประกอบของโปรโตคอลมีบทบาทดังนี้:

Agent Card

คล้ายกับ MCP Server ที่แชร์รายการเครื่องมือ Agent Card มี:

- ชื่อของ Agent

- คำอธิบายงานทั่วไป ที่ Agent สามารถทำได้

- รายการทักษะเฉพาะ พร้อมคำอธิบายเพื่อช่วยให้ Agents อื่น ๆ (หรือแม้แต่ผู้ใช้) เข้าใจว่าเมื่อใดและทำไมจึงควรเรียกใช้ Agent นั้น

- Endpoint URL ปัจจุบัน ของ Agent

- เวอร์ชัน และ ความสามารถ ของ Agent เช่น การตอบกลับแบบสตรีมและการแจ้งเตือนแบบพุช

Agent Executor

Agent Executor มีหน้าที่ ส่งบริบทของการสนทนาผู้ใช้ไปยัง Agent ระยะไกล Agent ระยะไกลต้องการสิ่งนี้เพื่อเข้าใจงานที่ต้องทำ ใน A2A Server Agent ใช้ LLM ของตัวเองเพื่อวิเคราะห์คำขอที่เข้ามาและดำเนินงานโดยใช้เครื่องมือภายในของตัวเอง

Artifact

เมื่อ Agent ระยะไกลทำงานที่ร้องขอเสร็จสิ้น ผลงานของมันจะถูกสร้างเป็น Artifact Artifact ประกอบด้วยผลลัพธ์ของงานที่ Agent ทำ คำอธิบายของสิ่งที่เสร็จสิ้น และ บริบทข้อความ ที่ส่งผ่านโปรโตคอล หลังจาก Artifact ถูกส่ง การเชื่อมต่อกับ Agent ระยะไกลจะถูกปิดจนกว่าจะต้องการอีกครั้ง

Event Queue

ส่วนประกอบนี้ใช้สำหรับ จัดการการอัปเดตและส่งข้อความ ซึ่งมีความสำคัญอย่างยิ่งในระบบ Agentic ที่ใช้งานจริงเพื่อป้องกันการปิดการเชื่อมต่อระหว่าง Agents ก่อนที่งานจะเสร็จสมบูรณ์ โดยเฉพาะอย่างยิ่งเมื่อเวลาที่ใช้ในการทำงานอาจนานขึ้น

ประโยชน์ของ A2A

• การทำงานร่วมกันที่เพิ่มขึ้น: ช่วยให้ Agents จากผู้ให้บริการและแพลตฟอร์มต่าง ๆ สื่อสาร แชร์บริบท และทำงานร่วมกันได้อย่างราบรื่น ช่วยให้เกิดการทำงานอัตโนมัติข้ามระบบที่มักจะไม่เชื่อมต่อกัน

• ความยืดหยุ่นในการเลือกโมเดล: แต่ละ A2A Agent สามารถตัดสินใจเลือก LLM ที่ใช้ในการให้บริการคำขอ ช่วยให้สามารถปรับแต่งหรือปรับโมเดลให้เหมาะสมต่อ Agent ได้ ซึ่งแตกต่างจากการเชื่อมต่อ LLM เดียวในบางสถานการณ์ของ MCP

• การรับรองความถูกต้องในตัว: การรับรองความถูกต้องถูกรวมเข้ากับโปรโตคอล A2A โดยตรง ให้กรอบความปลอดภัยที่แข็งแกร่งสำหรับการโต้ตอบระหว่าง Agents

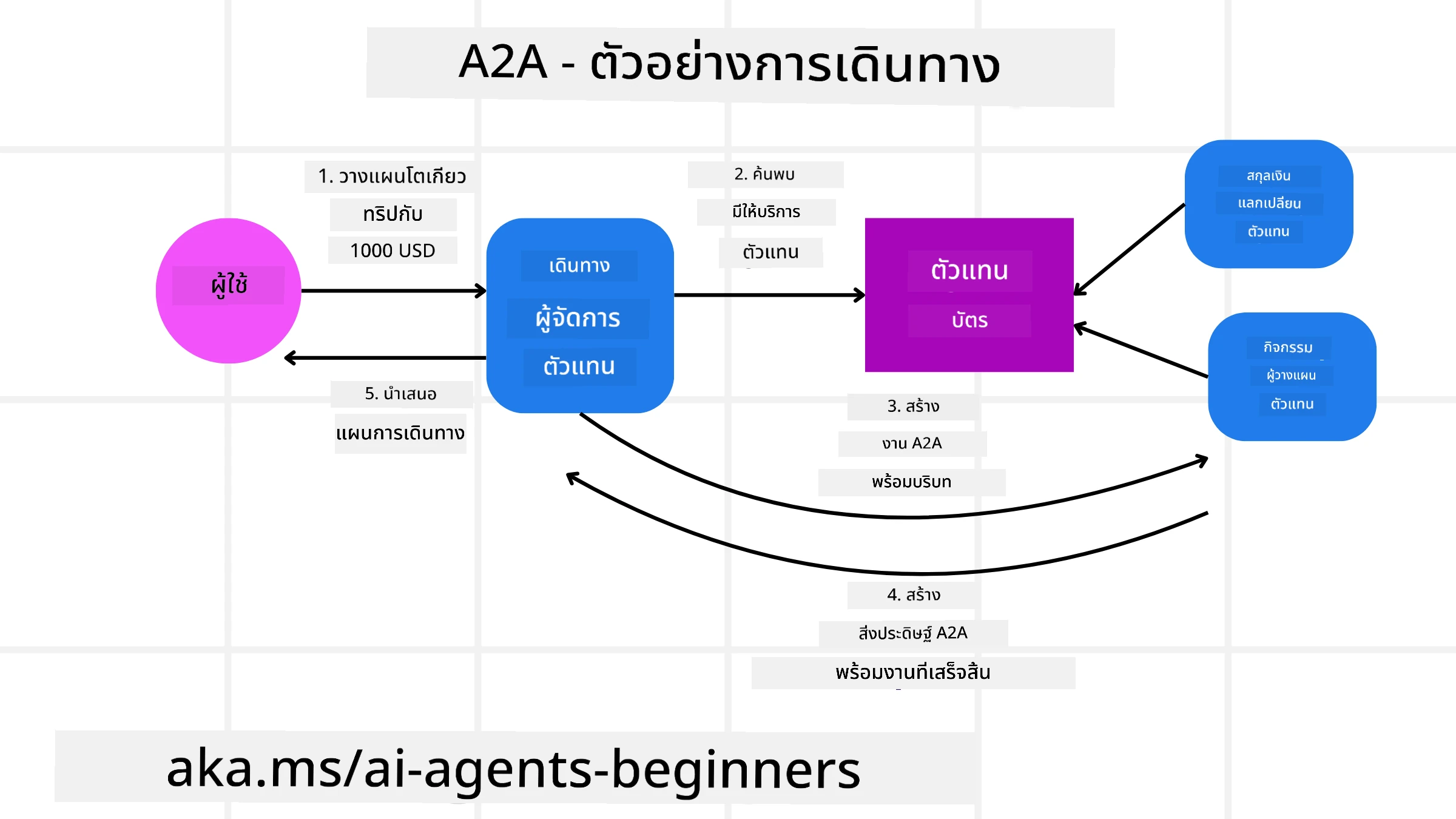

ตัวอย่าง A2A

ลองขยายสถานการณ์การจองการเดินทางของเรา แต่คราวนี้ใช้ A2A

-

คำขอผู้ใช้ไปยัง Multi-Agent: ผู้ใช้โต้ตอบกับ “Travel Agent” A2A Client/Agent โดยอาจพูดว่า “กรุณาจองทริปไป Honolulu สำหรับสัปดาห์หน้า รวมถึงเที่ยวบิน โรงแรม และรถเช่า”

-

การจัดการโดย Travel Agent: Travel Agent รับคำขอที่ซับซ้อนนี้ ใช้ LLM เพื่อวิเคราะห์งานและตัดสินใจว่าต้องโต้ตอบกับ Agents เฉพาะทางอื่น ๆ

-

การสื่อสารระหว่าง Agents: Travel Agent ใช้โปรโตคอล A2A เพื่อเชื่อมต่อกับ Agents เฉพาะทาง เช่น “Airline Agent,” “Hotel Agent,” และ “Car Rental Agent” ที่สร้างโดยบริษัทต่าง ๆ

-

การดำเนินงานที่มอบหมาย: Travel Agent ส่งงานเฉพาะไปยัง Agents เฉพาะทางเหล่านี้ (เช่น “ค้นหาเที่ยวบินไป Honolulu,” “จองโรงแรม,” “เช่ารถ”) แต่ละ Agent เฉพาะทางใช้ LLM ของตัวเองและเครื่องมือของตัวเอง (ซึ่งอาจเป็น MCP Servers) เพื่อดำเนินงานเฉพาะของการจอง

-

การตอบกลับที่รวมกัน: เมื่อ Agents เฉพาะทางทั้งหมดทำงานเสร็จ Travel Agent รวบรวมผลลัพธ์ (รายละเอียดเที่ยวบิน การยืนยันโรงแรม การจองรถเช่า) และส่งคำตอบแบบแชทที่ครอบคลุมกลับไปยังผู้ใช้

Natural Language Web (NLWeb)

เว็บไซต์เป็นวิธีหลักที่ผู้ใช้เข้าถึงข้อมูลและข้อมูลทั่วอินเทอร์เน็ตมาโดยตลอด

เรามาดูส่วนประกอบต่าง ๆ ของ NLWeb, ประโยชน์ของ NLWeb และตัวอย่างการทำงานของ NLWeb โดยดูจากแอปพลิเคชันการเดินทางของเรา

ส่วนประกอบของ NLWeb

-

NLWeb Application (Core Service Code): ระบบที่ประมวลผลคำถามภาษาธรรมชาติ เชื่อมต่อส่วนต่าง ๆ ของแพลตฟอร์มเพื่อสร้างคำตอบ คุณสามารถคิดว่ามันเป็น เครื่องยนต์ที่ขับเคลื่อนฟีเจอร์ภาษาธรรมชาติ ของเว็บไซต์

-

NLWeb Protocol: เป็น ชุดกฎพื้นฐานสำหรับการโต้ตอบภาษาธรรมชาติกับเว็บไซต์ ส่งคำตอบกลับในรูปแบบ JSON (มักใช้ Schema.org) จุดประสงค์คือการสร้างพื้นฐานง่าย ๆ สำหรับ “AI Web” ในลักษณะเดียวกับที่ HTML ทำให้สามารถแชร์เอกสารออนไลน์ได้

-

MCP Server (Model Context Protocol Endpoint): การตั้งค่า NLWeb แต่ละครั้งยังทำงานเป็น MCP Server ซึ่งหมายความว่าสามารถ แชร์เครื่องมือ (เช่น วิธี “ask”) และข้อมูล กับระบบ AI อื่น ๆ ได้ ในทางปฏิบัติ สิ่งนี้ทำให้เนื้อหาและความสามารถของเว็บไซต์สามารถใช้งานได้โดย AI Agents ทำให้เว็บไซต์กลายเป็นส่วนหนึ่งของ “ระบบ Agent” ที่กว้างขึ้น

-

Embedding Models: โมเดลเหล่านี้ใช้เพื่อ แปลงเนื้อหาเว็บไซต์เป็นตัวแทนเชิงตัวเลขที่เรียกว่าเวกเตอร์ (embeddings) เวกเตอร์เหล่านี้จับความหมายในลักษณะที่คอมพิวเตอร์สามารถเปรียบเทียบและค้นหาได้ ถูกจัดเก็บในฐานข้อมูลพิเศษ และผู้ใช้สามารถเลือกโมเดล embedding ที่ต้องการใช้ได้

-

Vector Database (Retrieval Mechanism): ฐานข้อมูลนี้ จัดเก็บ embeddings ของเนื้อหาเว็บไซต์ เมื่อมีคนถามคำถาม NLWeb จะตรวจสอบฐานข้อมูลเวกเตอร์เพื่อค้นหาข้อมูลที่เกี่ยวข้องมากที่สุดอย่างรวดเร็ว ให้รายการคำตอบที่เป็นไปได้อย่างรวดเร็ว โดยจัดอันดับตามความคล้ายคลึงกัน NLWeb ทำงานร่วมกับระบบจัดเก็บเวกเตอร์ต่าง ๆ เช่น Qdrant, Snowflake, Milvus, Azure AI Search และ Elasticsearch

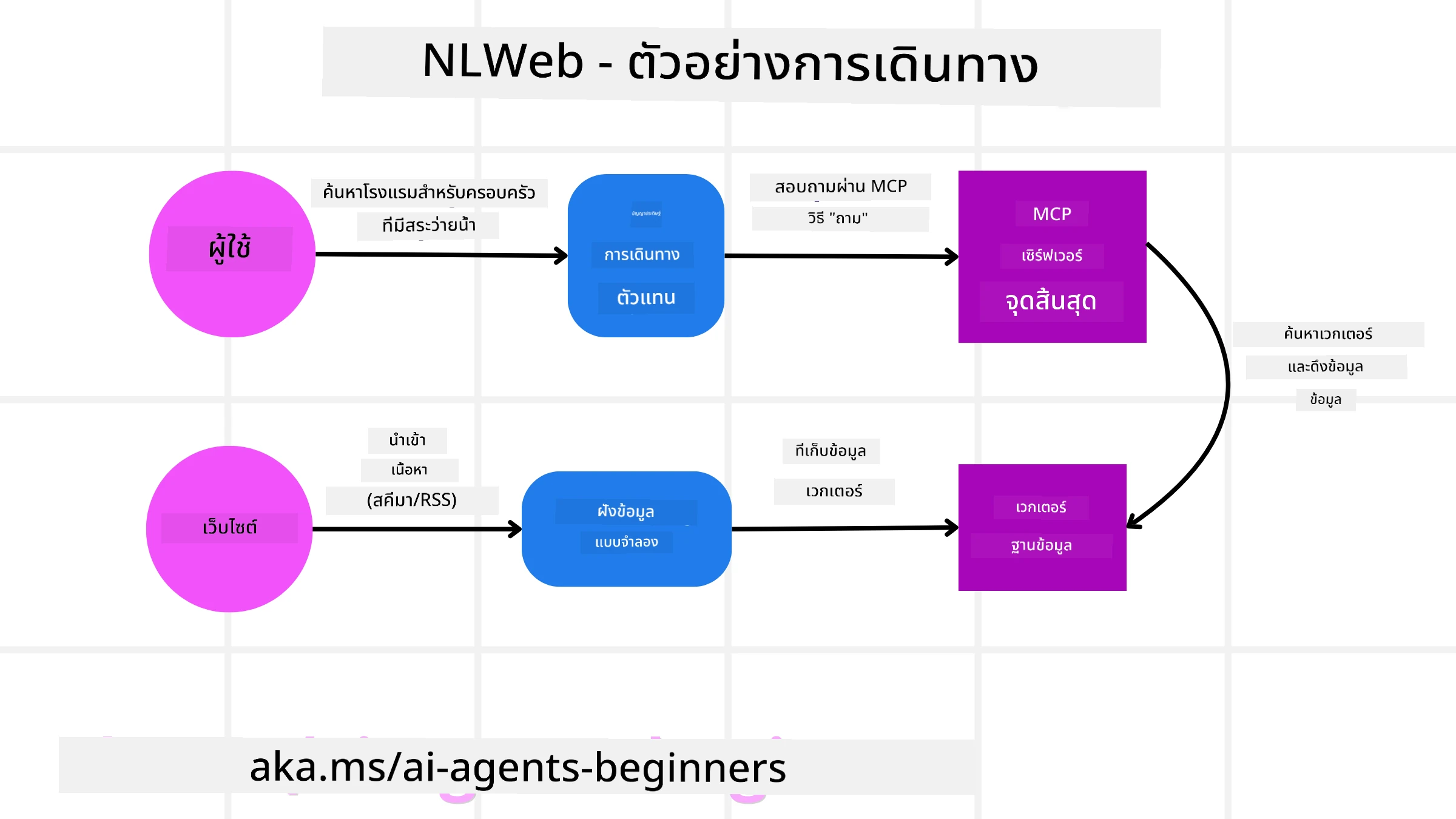

ตัวอย่าง NLWeb

ลองพิจารณาเว็บไซต์การจองการเดินทางของเราอีกครั้ง แต่คราวนี้ขับเคลื่อนด้วย NLWeb

-

การนำเข้าข้อมูล: แคตตาล็อกผลิตภัณฑ์ที่มีอยู่ของเว็บไซต์การเดินทาง (เช่น รายการเที่ยวบิน คำอธิบายโรงแรม แพ็คเกจทัวร์) ถูกจัดรูปแบบโดยใช้ Schema.org หรือโหลดผ่าน RSS feeds เครื่องมือของ NLWeb นำเข้าข้อมูลที่มีโครงสร้างนี้ สร้าง embeddings และจัดเก็บไว้ในฐานข้อมูลเวกเตอร์ในพื้นที่หรือระยะไกล

-

การค้นหาภาษาธรรมชาติ (มนุษย์): ผู้ใช้เยี่ยมชมเว็บไซต์และแทนที่จะนำทางผ่านเมนู พิมพ์ลงในอินเทอร์เฟซแชท: “ค้นหาโรงแรมที่เหมาะสำหรับครอบครัวใน Honolulu ที่มีสระว่ายน้ำสำหรับสัปดาห์หน้า”

-

การประมวลผล NLWeb: แอปพลิเคชัน NLWeb รับคำถามนี้ ส่งคำถามไปยัง LLM เพื่อทำความเข้าใจ และค้นหาฐานข้อมูลเวกเตอร์สำหรับรายการโรงแรมที่เกี่ยวข้องในเวลาเดียวกัน

-

ผลลัพธ์ที่แม่นยำ: LLM ช่วยตีความผลการค้นหาจากฐานข้อมูล ระบุการจับคู่ที่ดีที่สุดตามเกณฑ์ “เหมาะสำหรับครอบครัว” “สระว่ายน้ำ” และ “Honolulu” และจัดรูปแบบคำตอบภาษาธรรมชาติที่เหมาะสม คำตอบอ้างอิงถึงโรงแรมจริงจากแคตตาล็อกของเว็บไซต์ หลีกเลี่ยงข้อมูลที่แต่งขึ้น

-

การโต้ตอบกับ AI Agent: เนื่องจาก NLWeb ทำหน้าที่เป็น MCP Server AI Travel Agent ภายนอกสามารถเชื่อมต่อกับ NLWeb Instance ของเว็บไซต์นี้ได้ AI Agent สามารถใช้วิธี

askของ MCP เพื่อสอบถามเว็บไซต์โดยตรง เช่นask("มีร้านอาหารที่เหมาะสำหรับมังสวิรัติในพื้นที่ Honolulu ที่โรงแรมแนะนำหรือไม่?")NLWeb Instance จะประมวลผลคำถามนี้ โดยใช้ฐานข้อมูลข้อมูลร้านอาหาร (ถ้ามี) และส่งคำตอบ JSON ที่มีโครงสร้างกลับมา

มีคำถามเพิ่มเติมเกี่ยวกับ MCP/A2A/NLWeb?

เข้าร่วม Azure AI Foundry Discord เพื่อพบปะกับผู้เรียนคนอื่น ๆ เข้าร่วมชั่วโมงให้คำปรึกษา และรับคำตอบสำหรับคำถามเกี่ยวกับ AI Agents ของคุณ

แหล่งข้อมูล

ข้อจำกัดความรับผิดชอบ:

เอกสารนี้ได้รับการแปลโดยใช้บริการแปลภาษา AI Co-op Translator แม้ว่าเราจะพยายามให้การแปลมีความถูกต้องมากที่สุด แต่โปรดทราบว่าการแปลอัตโนมัติอาจมีข้อผิดพลาดหรือความไม่ถูกต้อง เอกสารต้นฉบับในภาษาดั้งเดิมควรถือเป็นแหล่งข้อมูลที่เชื่อถือได้ สำหรับข้อมูลที่สำคัญ ขอแนะนำให้ใช้บริการแปลภาษาจากผู้เชี่ยวชาญ เราไม่รับผิดชอบต่อความเข้าใจผิดหรือการตีความที่ผิดพลาดซึ่งเกิดจากการใช้การแปลนี้